Elina Filatova, Data Scientist bei NeuronUP, erläutert in diesem Artikel, wie das Modell Time-Aware LSTM (TA-LSTM) es ermöglicht, die Ergebnisse der Nutzer mit hoher Genauigkeit vorherzusagen, selbst wenn ihre Daten unregelmäßig erzeugt werden.

Bei NeuronUP setzen wir aktiv die fortschrittlichsten Methoden des maschinellen Lernens ein, die es uns ermöglichen, das Verhalten der Nutzer mit hoher Genauigkeit vorherzusagen, Trends zu erkennen und zukünftige Ergebnisse auf der Basis ihrer historischen Daten zu prognostizieren.

Allerdings stoßen traditionelle Ansätze des maschinellen Lernens an ihre Grenzen, wenn Daten unregelmäßig erzeugt werden und die Intervalle zwischen den Beobachtungen chaotisch oder benutzerspezifisch sind. In solchen Fällen werden konventionelle Modelle ineffektiv, da sie das individuelle Tempo und die Frequenz der Aktivitäten jeder Person nicht berücksichtigen.

Genau um dieses Problem zu lösen, verwenden wir eine spezielle Version des LSTM-Neuronalen Netzes, die als Time-Aware LSTM (TA-LSTM) bezeichnet wird. Dieses Modell kann die Zeitintervalle zwischen Ereignissen effektiv berücksichtigen und erlaubt die Vorhersage zeitlicher Abläufe, selbst wenn die Daten unregelmäßig sind.

Ziel der Studie und Hauptschwierigkeiten

Bei NeuronUP verfügen wir über Nutzermetriken aus vergangenen Tagen, um ihre Ergebnisse beim nächsten Aktivitätsdurchgang vorherzusagen. Auf den ersten Blick mag dies nach einer einfachen Aufgabe aussehen, doch in der Praxis ergeben sich mehrere wesentliche Schwierigkeiten:

- Individuelles Nutzertempo: Jeder Nutzer hat ein einzigartiges Trainingsmuster; manche spielen täglich, andere wöchentlich, und einige können längere Pausen von bis zu einem Monat einlegen und kehren unerwartet zu den Aktivitäten zurück. Zum Beispiel trainiert Alex jeden Tag regelmäßig, während José wöchentliche Intervalle bevorzugt. Wenn man ihre Ergebnisse ohne Berücksichtigung dieser Frequenz mittelt, gehen wichtige Details verloren.

- Vielfalt der Aktivitäten und ihre unterschiedliche Wirkung auf die Nutzer: Die Aktivitäten bei NeuronUP sind darauf ausgelegt, verschiedene kognitive Funktionen wie Gedächtnis, Aufmerksamkeit und Logik zu verbessern. Jede Aktivität hat ein bestimmtes Schwierigkeitsniveau, das je nach Nutzer variiert. Was für eine Person einfach ist, kann für eine andere eine große Herausforderung darstellen.

- Fokus auf spezifische Aktivitäten: Die Spezialisten bei NeuronUP legen fest, welche Aktivitäten jedem Nutzer zugewiesen werden. Beispielsweise führt Carmen regelmäßig Übungen zu Gedächtnis, Logik und Mathematik durch, während Pablo ausschließlich Aufmerksamkeitsübungen bevorzugt. Daher muss das prädiktive Modell den personalisierten Weg jedes Spielers berücksichtigen.

Natürlich erschweren all diese Nuancen sowohl den ordnungsgemäßen Datenaufbereitungsprozess als auch das eigentliche Training der Machine-Learning-Modelle. Ignoriert man das individuelle Tempo der Spieler, ihre unregelmäßigen Intervalle und die unterschiedlichen Schwierigkeitsstufen der Aktivitäten, geht zwangsläufig wichtige Information verloren. In der Folge besteht das Risiko ungenauerer Vorhersagen, was wiederum die Wirksamkeit personalisierter Empfehlungen bei NeuronUP verringern kann.

Melden Sie sich

für unseren

Newsletter an

Lösung: Time-Aware LSTM

Um alle zuvor genannten Herausforderungen effektiv zu meistern, hat das Data-Team von NeuronUP eine spezifische Lösung auf Basis des maßgeschneiderten Time-Aware LSTM (TA-LSTM) entwickelt. Dies ist eine erweiterte Version des Standard-LSTM-Neuronalen Netzes, das nicht nur Ereignisse in Zeitreihen berücksichtigt, sondern auch die Zeitintervalle dazwischen.

Datenaufbereitung: Warum ist der Zeitunterschied so wichtig?

Unser Modell erhält als Eingabe auf eine bestimmte Weise aufbereitete Daten. Jeder Datensatz ist eine zweidimensionale Matrix, die die sequentiellen Ergebnisse eines Spielers chronologisch geordnet enthält, sowie die Zeitintervalle in Tagen zwischen den einzelnen Aktivitätsdurchgängen. Um zu verstehen, warum die Berücksichtigung des Zeitunterschieds so wichtig ist, lernen wir zwei Figuren kennen, die uns diesen Punkt anschaulich erklären.

Stellen wir uns einen Marathon namens „Der Schnellste und Geschickteste“ vor, für den sich zwei Athleten vorbereiten:

- Neuronito – ein disziplinierter und entschlossener Sportler. Er überspringt nie ein Training, arbeitet jeden Tag an sich und achtet sorgfältig auf seine Ernährung. Neuronito macht ständig Fortschritte: Mit jeder neuen Trainingseinheit wird er schneller, ausdauernder und selbstbewusster. Aufgrund seines gleichmäßigen Trainingsrhythmus können wir leicht vorhersagen, dass er beim Marathon eine hervorragende Leistung erbringen wird.

- Lentonito – ein talentierter, aber weniger disziplinierter Athlet. Seine Trainings sind unregelmäßig. Heute trainiert er mit Begeisterung, morgen zieht er es vor, sich bei einer Paella und gutem Schinken zu entspannen. Diese inkonstanten Einheiten führen zu Schwankungen in seiner Leistung: Mal verbessert er sich, mal nicht, aber ohne kontinuierliches Wachstum. Wahrscheinlich wird Lentonito weniger beeindruckende Ergebnisse im Ziel erreichen.

Auf diese Weise haben wir anhand eines einfachen Beispiels gesehen, wie stark die Zeitintervalle zwischen Ereignissen das Endergebnis beeinflussen. Genau diese Informationen über Stabilität und Regelmäßigkeit der „Trainings“ geben wir unserem Modell.

Wenn wir die Zeitintervalle nicht berücksichtigen, würde das Modell diese beiden Athleten als gleich wahrnehmen, ohne die Unterschiede in ihrer Trainingsweise zu bemerken. TA-LSTM hingegen erkennt dieses Schlüsselmerkmal, analysiert die individuellen Intervalle zwischen den Ereignissen und liefert präzisere Vorhersagen, indem es das einzigartige Tempo jedes Teilnehmers (oder in unserem Fall jedes Nutzers bei NeuronUP) berücksichtigt.

Aber das ist noch nicht alles! Wie du sicherlich bemerkt hast, haben wir auch die Ernährung von Neuronito und Lentonito erwähnt. Das geschieht nicht zufällig, sondern weil diese Daten zusätzliche Merkmale darstellen, die das Endergebnis ebenfalls erheblich beeinflussen.

Ähnlich ist unser Modell in der Lage, nicht nur die Zeitintervalle, sondern auch weitere wichtige Merkmale wie Alter, Geschlecht, Diagnose und sogar die Nutzerpräferenzen zu berücksichtigen.

Dies ermöglicht eine erhebliche Verbesserung der Vorhersagegenauigkeit, wie in unserem Beispiel mit den Protagonisten, in dem wir ihre Ernährungsgewohnheiten und deren Einfluss auf den Erfolg berücksichtigt haben.

Technische Details

Nachdem wir das Grundkonzept betrachtet haben, wenden wir uns nun dem technischen Aspekt der Funktionsweise des Time-Aware LSTM (TA-LSTM)-Modells zu. Dieses Modell ist eine Modifikation der Standard-LSTM-Zelle, die speziell dafür entwickelt wurde, die Zeitintervalle zwischen sequentiellen Ereignissen zu berücksichtigen.

Das Hauptziel von TA-LSTM ist die adaptive Aktualisierung des internen Speicherzustands des Modells in Abhängigkeit von der seit der letzten Beobachtung verstrichenen Zeit. Dieser Ansatz ist entscheidend, wenn man mit unregelmäßigen Zeitreihen arbeitet – genau der Datentyp, mit dem wir bei NeuronUP umgehen.

Der Eingabevektor zum Zeitpunkt t wird dargestellt als:

\[\text{inputs}_{t} = [x_{t},\,\Delta t]\]Dabei gilt:

- \(x_t \in \mathbb{R}^d\) – ist der Merkmalsvektor, der das aktuelle Ereignis beschreibt (jeder Tag, an dem die Aktivität durchgeführt wird).

- \(\Delta t \in \mathbb{R}\) – ist das Zeitintervall zwischen der aktuellen und der vorherigen Beobachtung.

Die vorherigen Zustände des Modells werden auf die Standardweise dargestellt:

\[h_{t-1},\; C_{t-1}\]Dabei gilt:

- \(h_{t-1}\) – ist der verborgene Zustandsvektor im vorherigen Schritt.

- \(C_{t-1}\) – ist der Speicherzustand (LSTM-Zelle) im vorherigen Schritt.

Um die Auswirkung des Zeitintervalls \(t\) zu berücksichtigen, nutzt das Modell einen speziellen Mechanismus zur Abschwächung des Speichers, der durch die folgende Formel beschrieben wird:

\[\gamma_t = e^{-\text{RELU}(w_d \cdot \Delta t + b_d)}\]Dabei gilt:

- \(w_d, \; b_d\) – sind trainierbare Parameter des Modells.

- \(\text{RELU}(x) = \max(0, x)\) – ist die Aktivierungsfunktion, die negative Werte verhindert.

Der Abschwächungskoeffizient \(\gamma_t\) steuert die Aktualisierung des Speicherzustands.

Die Aktualisierung des Speichers wird definiert durch:

\[\bar{C}_{t-1} = \gamma_t \cdot C_{t-1}\]Dies bedeutet, dass wenn das Zeitintervall \(\Delta t\) zunimmt, der Wert von \(\gamma_t\) gegen Null geht, was zu einem stärkeren „Vergessen“ der vorherigen Speicherzustände führt.

Im nächsten Schritt wird der korrigierte Speicherzustand \(\bar{C}_{t-1}\) in die Standardgleichungen des LSTM eingespeist:

\[h_t, \; C_t = \text{LSTM}(x_{t‘}, h_{t-1}, \bar{C}_{t-1})\]Die Ausgabewerte \(h_t\) und der aktualisierte Speicherzustand \(C_t\) werden im nächsten Modellschritt verwendet, wodurch präzise Vorhersagen und die Berücksichtigung unregelmäßiger Zeitintervalle zwischen Ereignissen gewährleistet sind.

Warum Vorhersagen nutzen?

Der Einsatz der Vorhersage erlaubt es uns, die zukünftigen Ergebnisse eines Patienten mit hoher Genauigkeit zu antizipieren, indem wir seine Daten zuvor mit unserem maßgeschneiderten TA-LSTM-Modell analysieren. Um die Genauigkeit der Vorhersagen zu überprüfen, haben wir eine Stichprobe realer Patientendaten genommen und das Modell auf Basis ihrer bisherigen Aktivitätsaufzeichnungen angewendet. Der letzte Aktivitätstag jedes Patienten wurde aus den Daten ausgeschlossen, um das tatsächliche Ergebnis mit der vom Modell generierten Vorhersage zu vergleichen.

In den meisten Fällen stimmten die vom Modell vorhergesagten Ergebnisse eng mit den tatsächlichen Werten der Spieler überein. Wir identifizierten jedoch auch einige interessante Ausnahmen, bei denen die Vorhersage deutlich vom realen Ergebnis abwich.

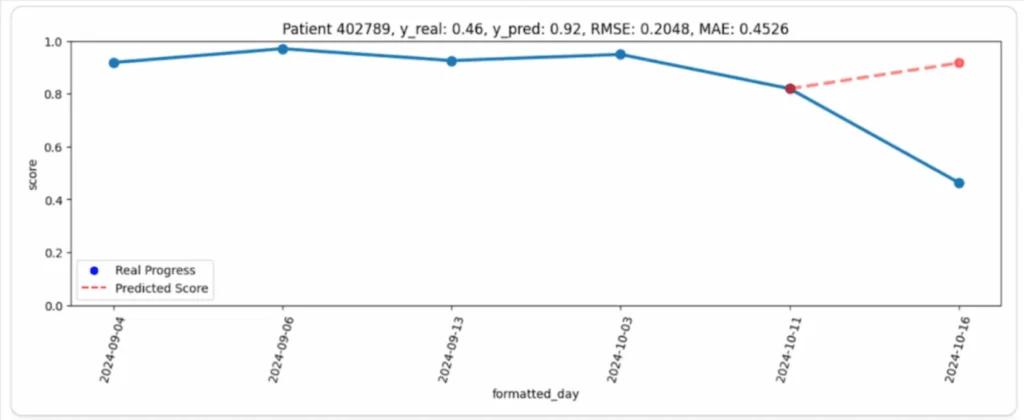

Beispielsweise ist in der nachfolgenden Grafik (Abbildung 1) der Verlauf des Patienten (blaue Linie) und die entsprechende Modellvorhersage (rote Linie) zu sehen. Auf den ersten Blick erscheint der Unterschied recht groß: Der Patient zeigte während des gesamten Beobachtungszeitraums eine hohe und stabile Leistung, doch sein letzter Wert war unerwartet deutlich niedriger als prognostiziert. In diesem Fall wirkte die Modellvorhersage deutlich plausibler als das tatsächliche Ergebnis.

Warum ist das passiert?

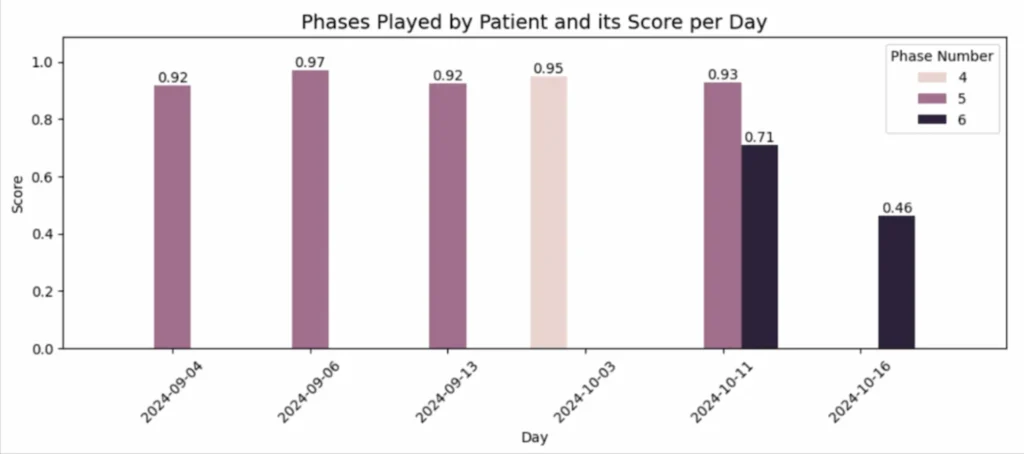

Der Grund erwies sich als einfach, aber wichtig: An allen vorangegangenen Tagen spielte der Patient auf einfacheren Leveln (Phasen) und erzielte durchgängig hohe Punktzahlen. Am letzten Tag wählte er jedoch Phase 6, die schwieriger war, was zu einem deutlichen Leistungsabfall führte (Abbildung 2).

Auf diese Weise ermöglichte die Modellvorhersage, eine unerwartete Abweichung vom üblichen Verhalten des Patienten zu erkennen und festzustellen, dass sie durch eine Erhöhung des Schwierigkeitsgrads verursacht wurde.

Dieser Ansatz bietet den Experten von NeuronUP ein leistungsstarkes Werkzeug, um derartige Situationen frühzeitig zu erkennen und die Ursachen der Abweichungen schnell zu analysieren.

Testen Sie NeuronUP 7 Tage kostenlos

Probieren Sie unsere verschiedenen Übungen, erstellen Sie Sitzungen oder arbeiten Sie remote mithilfe von Online-Sitzungen

Fazit

Der Einsatz von Time-Aware LSTM eröffnet neue Möglichkeiten für die präzise Vorhersage von Zeitreihen mit unregelmäßigen Intervallen. Im Gegensatz zu traditionellen Modellen ist TA-LSTM in der Lage, sich dem einzigartigen Tempo jedes Spielers anzupassen, indem es Pausen und Aktivitätsintervalle berücksichtigt. Dank dieses Ansatzes kann unsere Plattform zur kognitiven Stimulation nicht nur zukünftige Ergebnisse der Patienten genau vorhersagen, sondern auch rechtzeitig mögliche Anomalien oder unerwartete Abweichungen erkennen.

Bei NeuronUP schätzen wir deine Zeit und streben stets danach, die effektivsten, innovativsten und fortschrittlichsten Technologien anzuwenden. Bleib auf dem Laufenden – das Beste kommt erst noch!

Literatur

- Lechner, Mathias, and Ramin Hasani. “Learning Long-Term Dependencies in Irregularly-Sampled Time Series.” arXiv preprint arXiv:2006.04418, Bd. –, Nr. –, 2020, S. 1–11.

- Michigan State University, et al. “Patient Subtyping via Time-Aware LSTM Networks.” Proceedings of the 23rd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining (KDD ’17), Bd. –, Nr. –, 2017, S. 65–74.

- Nguyen, An, et al. “Time Matters: Time-Aware LSTMs for Predictive Business Process Monitoring.” Lecture Notes in Business Information Processing, Process Mining Workshops, Bd. 406, Nr. –, 2021, S. 112–123.

- Schirmer, Mona, et al. “Modeling Irregular Time Series with Continuous Recurrent Units.” Proceedings of the 39th International Conference on Machine Learning (ICML 2022), Bd. 162, Nr. –, 2022, S. 19388–19405.

- “Time aware long short-term memory.” Wikipedia, https://en.wikipedia.org/wiki/Time_aware_long_short-term_memory. Abgerufen am 12. März 2025.

Wenn dir dieser Artikel über die Vorhersage von Spielergebnissen mittels TA-LSTM gefallen hat, könnten dich auch diese Artikel von NeuronUP interessieren:

Dieser Artikel wurde übersetzt; Link zum Originalartikel auf Spanisch:

Predicción de resultados de jugadores mediante TA-LSTM.

Die Digitalisierung in der neuropsychologischen Diagnostik

Die Digitalisierung in der neuropsychologischen Diagnostik

Schreiben Sie einen Kommentar