In questo articolo, Antonio Javier Sutil Jiménez parla dello studio “Previsione dell’incidenza della malattia di Alzheimer tramite machine learning utilizzando dati sanitari amministrativi su larga scala”.

Perché è importante lo studio sulla previsione dell’Alzheimer con il machine learning?

Il progresso della tecnologia può, a volte, fornire soluzioni inaspettate a problemi medici. Un esempio di ciò è l’uso di dati amministrativi sanitari per creare modelli predittivi del rischio di sviluppare la malattia di Alzheimer.

La grande novità del lavoro di Park e collaboratori è stato lo sfruttamento di questa enorme quantità di dati che, come descritto dai ricercatori, sono ancora in molti casi non utilizzati. Pertanto, la digitalizzazione delle cartelle cliniche è diventata una risorsa di grande valore per ridurre gli sforzi e i costi di raccolta dei dati.

Nonostante ciò, la sua applicazione a malattie come l’Alzheimer era stata limitata. In parte, questo problema è stato risolto grazie al aumento della capacità computazionale, che permette di applicare tecniche di machine learning all’analisi dei dati e creare modelli predittivi rappresentativi della popolazione, grazie a campioni sufficientemente ampi.

Premessa dello studio

Per la realizzazione dello studio, si parte dal presupposto che l’uso di dati di individui a rischio di sviluppare la malattia di Alzheimer consenta una migliore individuazione precoce dei casi in fase preclinica e, di conseguenza, il miglioramento delle strategie terapeutiche.

Per raggiungere questo obiettivo, il gruppo di ricercatori ha avuto accesso al database del sistema sanitario nazionale della Corea, che conteneva oltre 40.000 cartelle cliniche di persone con più di 65 anni, con una grande quantità di informazioni come storia personale, precedenti familiari, dati sociodemografici, diagnosi, prescrizioni, ecc.

Cosa è stato fatto?

Dataset

Per realizzare lo studio, è stata presa una coorte del NHIS-NSC (The National Health Insurance Service–National Sample Cohort) della Corea del Sud, che includeva oltre un milione di partecipanti, monitorati per undici anni (dal 2002 al 2013).

Il database conteneva informazioni sui servizi sanitari, diagnosi e prescrizioni di ciascun individuo, nonché caratteristiche cliniche, inclusi dati demografici, livelli di reddito basati sul salario mensile, codici di malattie e farmaci, valori di laboratorio, profili di salute e storie cliniche personali e familiari. Da questo campione, sono stati selezionati 40.736 adulti con più di 40 anni per questo studio.

Definizione operativa della malattia di Alzheimer

Successivamente, è stata creata una definizione operativa della malattia di Alzheimer, basata sull’algoritmo di uno studio canadese precedente.

Questo algoritmo ha ottenuto una sensibilità del 79% e una specificità del 99%, includendo codici di ospedalizzazione, richieste mediche e prescrizioni specifiche per l’Alzheimer.

Per migliorare la precisione nel rilevamento della malattia, sono state utilizzate le etichette “definite AD” per i casi in cui si aveva un alto grado di certezza e “probable AD” per i casi confermati solo attraverso i codici ICD-10 (acronimo della Classificazione Internazionale delle Malattie), al fine di minimizzare i falsi negativi. Con queste etichette, è stata rilevata una prevalenza della malattia di Alzheimer dell’1,5% per “definite AD” e del 4,9% per “probable AD”.

Analisi

Per l’analisi e il trattamento dei dati, sono state utilizzate caratteristiche come età e sesso, oltre a 21 variabili provenienti dal database NHIS-NSC, che includevano profili di salute e storie cliniche familiari, insieme a oltre 6.000 variabili derivate dai codici ICD-10 e dai farmaci.

Una volta descritte le caratteristiche, queste sono state allineate concentrandosi sull’incidenza della diagnosi per ciascun individuo, in base ai codici ICD-10 e ai codici dei farmaci. Questo ha permesso di eliminare malattie rare e codici di farmaci con bassa frequenza. Inoltre, sono stati esclusi gli individui senza nuovi dati sanitari negli ultimi due anni. Il set finale di variabili utilizzate nei modelli ha incluso 4.894 caratteristiche uniche.

Per effettuare le previsioni a “n” anni nel gruppo con malattia di Alzheimer, sono stati utilizzati intervalli temporali tra il 2002 e l’anno di incidenza. Nel gruppo senza malattia, sono stati presi i dati dal 2002 fino al 2010-n.

Infine, prima di implementare il modello, sono stati creati sottogruppi di addestramento, validazione e test utilizzando sia un set di dati bilanciato e campionato casualmente, sia un set di dati non bilanciato.

Applicazione delle tecniche di machine learning (ML)

Infine, è stata realizzata l’analisi dei dati implementando tecniche di machine learning come random forest, support vector machine con kernel lineare e regressione logistica.

L’addestramento, la validazione e i test sono stati eseguiti utilizzando la validazione incrociata stratificata con 5 iterazioni.

La selezione delle caratteristiche è stata effettuata all’interno dei campioni di addestramento utilizzando un metodo di soglia di varianza, e la generalizzazione delle prestazioni del modello è stata valutata sui campioni di test.

Per verificare le prestazioni del modello, sono state utilizzate metriche comuni, come l’area sotto la curva ROC, la sensibilità e la specificità.

Per maggiori dettagli su come è stato condotto questo studio, si consiglia di consultare l’articolo originale.

Quali sono le principali conclusioni di questo studio sulla previsione dell’Alzheimer con machine learning?

Il lavoro evidenzia il potenziale delle tecniche di apprendimento automatico basate sui dati come uno strumento promettente per prevedere il rischio di demenza di tipo Alzheimer.

Vantaggio principale dello studio

Questo studio presenta un grande vantaggio rispetto ad altri approcci basati su informazioni ottenute da test di neuroimaging o valutazioni neuropsicologiche, poiché è stato condotto utilizzando esclusivamente dati amministrativi.

Mentre altri studi si concentrano su popolazioni che sono già in una situazione di rischio clinico reale o che hanno mostrato sufficiente preoccupazione da consultare un professionista della salute, questo approccio sfrutta la disponibilità di dati amministrativi per identificare i rischi senza necessità di valutazioni cliniche preliminari.

| Definite AD | Probabile AD | Non-AD | |

| Nº | 614 | 2026 | 38.710 |

| Età | 80.7 | 79.2 | 74.5 |

| Sesso (uomo, donna) | 229, 285 | 733, 1293 | 18.200, 20.510 |

Di seguito sono riportate le tabelle comparative tra definite AD e non AD, e probabile AD e non AD per gli anni di previsione 0 e 4 con tutti i classificatori utilizzati nello studio.

| Anni di previsione | Classificatore | Metriche | |||

| Precisione | AUC | Sensibilità | Specificità | ||

| 0 anni | Regressione logistica | 0.76 | 0.794 | 0.726 | 0.793 |

| Support Vector Model | 0.763 | 0.817 | 0.795 | 0.811 | |

| Random Forest | 0.823 | 0.898 | 0.509 | 0.852 | |

| 4 anni | Regressione logistica | 0.627 | 0.661 | 0.509 | 0.745 |

| Support Vector Model | 0.646 | 0.685 | 0.538 | 0.754 | |

| Random Forest | 0.663 | 0.725 | 0.621 | 0.705 |

| Anni di previsione | Classificatore | Metriche | |||

| Precisione | AUC | Sensibilità | Specificità | ||

| 0 anni | Regressione logistica | 0.763 | 0.783 | 0.689 | 0.783 |

| Support Vector Model | 0.734 | 0.794 | 0.652 | 0.816 | |

| Random Forest | 0.788 | 0.850 | 0.723 | 0.853 | |

| 4 anni | Regressione logistica | 0.611 | 0.644 | 0.516 | 0.707 |

| Support Vector Model | 0.601 | 0.641 | 0.465 | 0.738 | |

| Random Forest | 0.641 | 0.683 | 0.603 | 0.679 |

Entrambe le tabelle presentate sono semplificazioni delle tabelle dell’articolo originale. In questo caso, il numero di anni è stato ridotto a soli due (0 e 4 anni) per gli anni di previsione.

Risultati per la previsione

Un altro aspetto di rilievo dell’articolo sono le caratteristiche importanti trovate per la previsione. Queste sono descritte come correlate positivamente o negativamente con l’incidenza della malattia di Alzheimer. Alcune delle caratteristiche correlate positivamente con lo sviluppo della malattia includono l’età, la presenza di proteina nelle urine e la prescrizione di zotepina (un antipsicotico).

Al contrario, sono state rilevate anche caratteristiche che si sono correlate negativamente con l’incidenza della malattia, come la diminuzione dell’emoglobina, la prescrizione di nicametato citrato (un vasodilatatore), i disturbi degenerativi del sistema nervoso e i disturbi dell’orecchio esterno.

Inoltre, il modello predittivo è stato testato utilizzando solo le 20 caratteristiche più importanti, e si è scoperto che il modello aveva una precisione per gli anni 0 e 1 molto simile all’originale.

È possibile la rilevazione basata sui dati amministrativi di salute?

La conclusione dello studio è che la rilevazione di individui a rischio di Alzheimer basata esclusivamente sui dati amministrativi di salute è possibile. Tuttavia, gli autori lasciano aperta la possibilità che futuri studi in diverse nazioni e sistemi sanitari possano confermare questi risultati. La replicazione di questi studi rappresenterebbe un passo importante per una rilevazione più precoce e accurata delle persone a rischio.

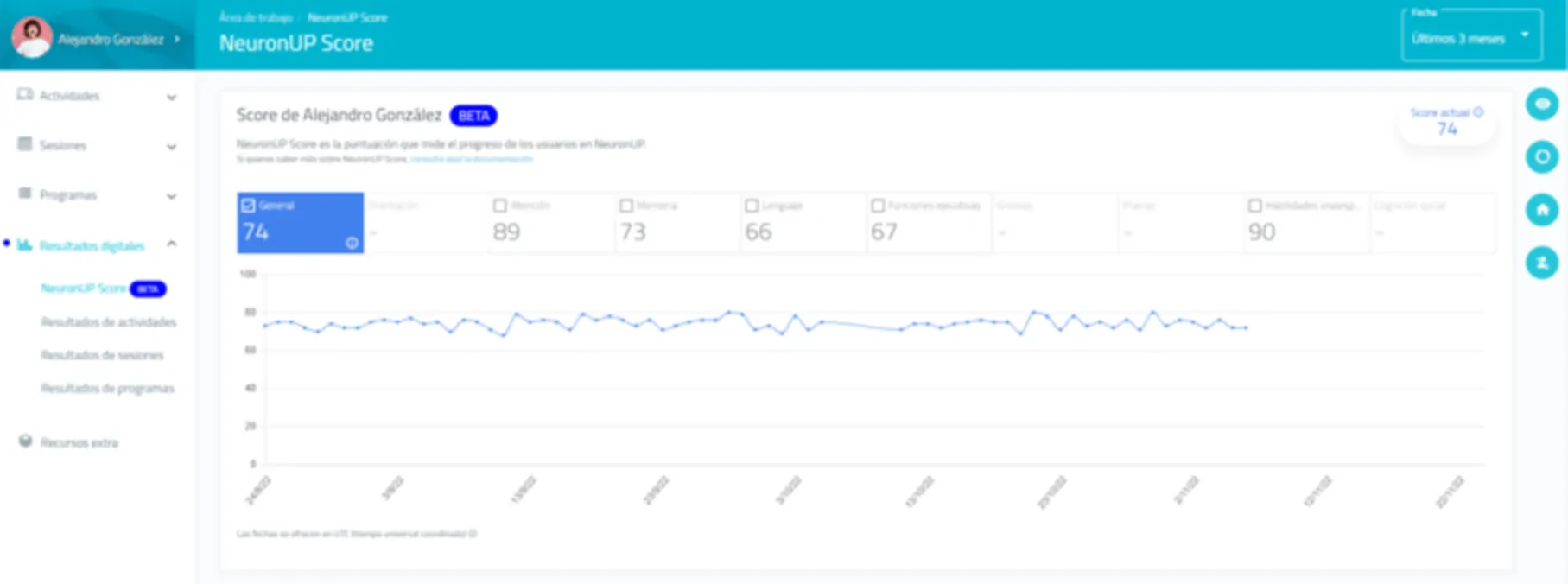

Dove NeuronUP potrebbe contribuire in uno studio come questo?

NeuronUP ha esperienza in ambito scientifico in due aree principali:

- Fornendo supporto a gruppi di ricerca interessati alla tecnologia,

- realizzando propri lavori da pubblicare in riviste di alto impatto scientifico.

In particolare, per studi con caratteristiche simili a quelli esaminati in questo articolo, riteniamo che, avendo accesso a grandi set di dati come quelli descritti, NeuronUP disponga del team e dell’esperienza necessari per:

- Da un lato, implementare tecniche sofisticate di apprendimento automatico, come quelle menzionate nell’articolo;

- e, dall’altro, nel design dello studio. Ovvero, dispone di un team qualificato per formulare domande basate sulla letteratura scientifica esistente, nonché per realizzare studi “data-driven” o guidati dai dati.

La particolarità degli studi data-driven è che sono incentrati sull’analisi e l’interpretazione dei dati. Questa prospettiva si basa sull’uso di grandi quantità di dati per scoprire pattern e tendenze nascoste.

L’uso di nuove tecnologie e avanzate tecniche di analisi, necessarie per lavorare con questi grandi set di dati, era difficilmente accessibile per la maggior parte dei ricercatori fino a pochi anni fa. Pertanto, questa prospettiva è importante e necessaria quando si dispone di grandi volumi di dati, poiché può offrire conclusioni innovative che non si otterrebbero utilizzando metodi basati esclusivamente sulla teoria.

Bibliografia

- Park, J.H., Cho, H.E., Kim, J.H. et al. Machine learning prediction of incidence of Alzheimer’s disease using large-scale administrative health data. npj Digit. Med. 3, 46 (2020). https://doi.org/10.1038/s41746-020-0256-0

Consumo di alcol durante la gravidanza: effetti sul cervello fetale e rischio di disabilità intellettiva.

Consumo di alcol durante la gravidanza: effetti sul cervello fetale e rischio di disabilità intellettiva.

Lascia un commento